Hoy Hablamos Sobre

¿Tus conversaciones con IA están siendo usadas para entrenarla?

Opt-in y opt-out de privacidad y transparencia

¿Tus conversaciones con IA están siendo usadas para entrenarla?

Si usas chatbots como ChatGPT, Gemini, Claude o Copilot, lo que escribes probablemente está entrenando al modelo detrás... sin que lo sepas realmente.

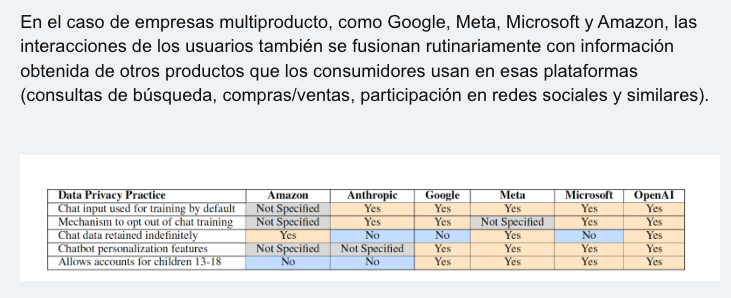

Un estudio del Instituto HAI de Stanford analizó las políticas de privacidad de seis grandes desarrolladores de IA en EE. UU. (Google, OpenAI, Anthropic, Meta, Microsoft y Amazon), y encontró un patrón preocupante:

- Todas usan por defecto lo que escribes en sus chats para mejorar sus modelos.

- Pocas explican claramente cómo recolectan, almacenan o comparten esa información.

- Algunas combinan estos datos con tu actividad en otras plataformas, como búsquedas, compras en línea o redes sociales.

- Y muchas no excluyen entradas de menores de edad, ni filtran datos sensibles como salud o biometría.

¿Qué significa esto para ti?

Desde preferencias alimenticias hasta estados de salud mental, tus inputs más personales pueden terminar influyendo en modelos que después te perfilan, te segmentan, o te muestran anuncios... sin tu consentimiento explícito.

La autora principal del estudio, Jennifer King, advierte que "si compartes información sensible en un diálogo con ChatGPT, Gemini u otros modelos, puede ser recolectada y usada para entrenamiento, incluso si está en un archivo que subiste durante la conversación".

Además, señala que "tenemos cientos de millones de personas interactuando con chatbots, que están recolectando datos personales para entrenamiento, y sin casi ninguna investigación que examine sus prácticas de privacidad".

Un ejemplo que da el estudio es revelador: si pides recetas bajas en azúcar o para el corazón, el modelo puede inferir que tienes una condición médica y esa información puede luego reflejarse en anuncios o incluso terminar en perfiles que afecten seguros o servicios.

Como enfatiza King:

“Necesitamos promover una IA que preserve la privacidad desde el diseño, para que proteger al usuario no sea un pensamiento posterior.”

¿Qué acciones puedes tomar?

- Opta por salir del uso de tus datos para entrenamiento (si te lo permiten).

- No compartas contenido sensible con chatbots.

- Consulta las políticas de privacidad, aunque sean poco legibles y extensas.

- Exige más transparencia y regulaciones claras por parte de las empresas tecnológicas.

¿Y a nivel institucional?

Las recomendaciones de Stanford apuntan a tres medidas clave:

- Una reforma regulatoria federal clara que proteja los datos personales.

- Consentimiento afirmativo para que los chats sean usados como datos de entrenamiento.

- Filtrado automático de información sensible antes de que sea utilizada por los modelos.

El equipo investigador también advierte sobre la falta de mecanismos independientes que verifiquen si las empresas cumplen lo que prometen en sus políticas de privacidad, lo que deja a los usuarios indefensos.

La IA conversacional es útil, sí. Pero es hora de preguntarnos: ¿a qué costo en términos de privacidad?

¿Confías en cómo las empresas de IA están usando tus datos? ¿Qué tipo de políticas exigirías tú?

Si te interesa seguir explorando estos dilemas con enfoque ético y estratégico, te va a encantar mi newsletter "IA con Sentido": lo esencial de IA responsable en español. Para suscribirte.

Quieres aprender más sobre la IA Responsable y Gobernanza de la IA, mira los artículos de blog que he redactado para ti.

Para cualquier duda que puedas tener, me puedes mandarme email a info@karine.ai, con mucho gusto te contestaré.