Hoy Hablamos Sobre

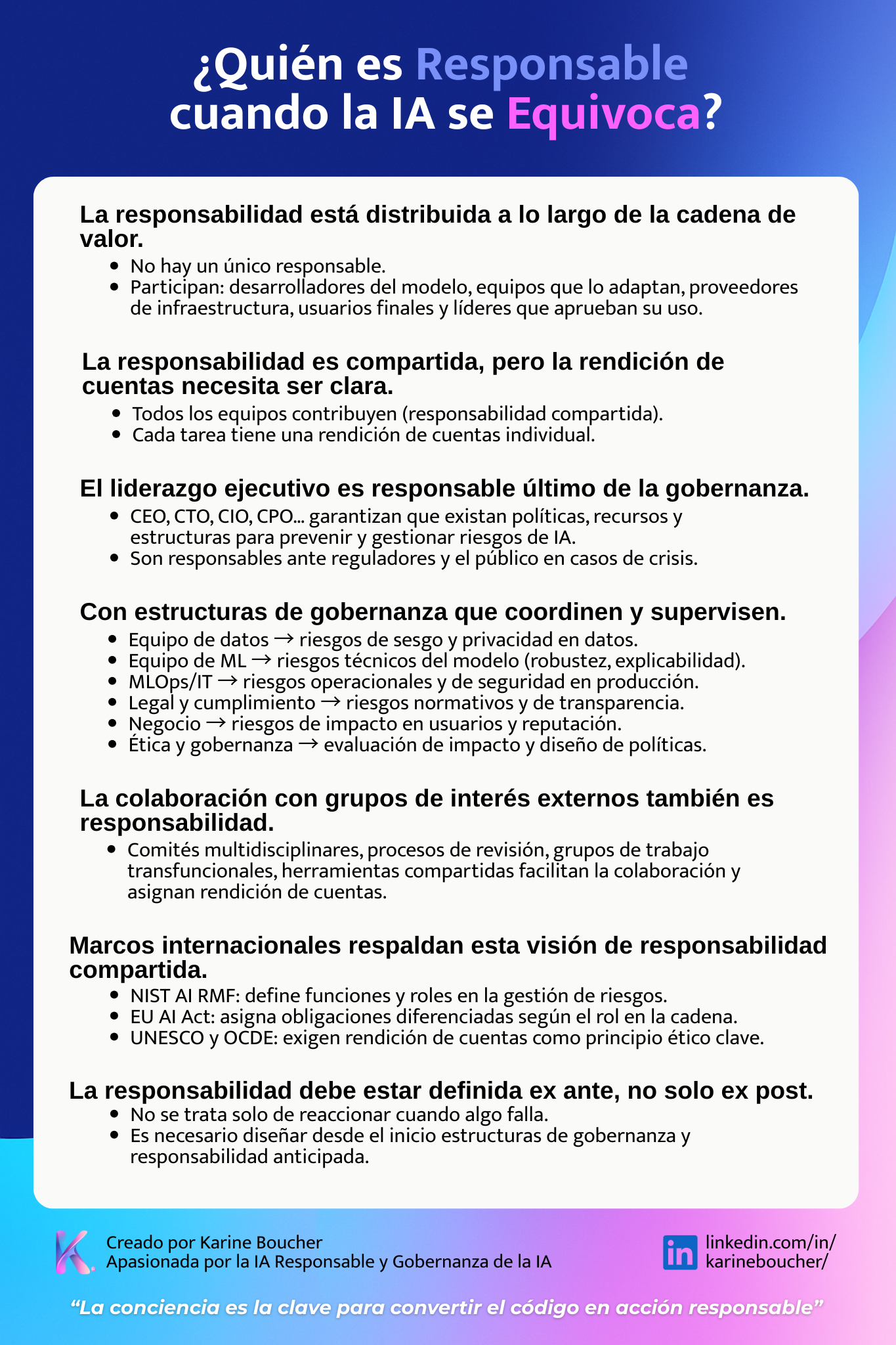

¿Quién es responsable cuando la IA se equivoca?

Explora cómo se gestiona la responsabilidad en la inteligencia artificial cuando ocurren errores, bajo marcos regulatorios y de gobernanza internacional

¿Quién es responsable cuando una IA comete un error?

Con la expansión del uso de inteligencia artificial (IA) en áreas críticas como salud, finanzas, contratación o justicia, las consecuencias de sus errores se vuelven cada vez más visibles. Pero cuando una IA falla, discrimina, margina o toma una mala decisión... ¿quién responde?

Esta pregunta no es solo técnica. Es legal, ética y organizacional. Y está en el centro de la gobernanza de la IA.

La cadena de valor de la IA: muchos actores, muchas decisiones

La IA moderna no es un sistema monolítico creado por una sola persona. Involucra una compleja cadena de valor con roles diversos:

- Proveedores de modelos fundacionales (foundation models)

- Equipos de adaptación o fine-tuning

- Infraestructura técnica y proveedores de servicios

- Usuarios finales que integran, despliegan o interactúan con el sistema

Esta fragmentación hace que la responsabilidad legal y ética se diluya. Pero también impide una gestión de riesgos efectiva si no se estructura con claridad.

Gobernanza y rendición de cuentas: lo que debe estar definido

Una cosa es la responsabilidad compartida: todos colaboran en la identificación y mitigación de riesgos. Otra, muy distinta, es la rendición de cuentas (accountability): alguien debe asumir la responsabilidad si las cosas salen mal.

Una buena gobernanza de IA establece claramente:

- ¿Quién toma qué decisiones?

- ¿Quién aprueba el uso de IA en un contexto sensible?

- ¿Quién revisa los riesgos y propone mitigaciones?

- ¿Quién debe responder ante un regulador o ante el público?

¿Qué dicen los marcos regulatorios internacionales?

El debate sobre la responsabilidad en IA no es nuevo, y varios marcos lo abordan directamente:

NIST AI Risk Management Framework (EE. UU.)

Plantea que los riesgos de IA deben gestionarse a lo largo de todo el ciclo de vida del sistema, involucrando funciones diversas dentro y fuera de la organización. El marco incluye principios de gobernanza, monitoreo y mejora continua, con especial énfasis en la colaboración transfuncional.

EU AI Act

La legislación europea sobre IA —la más avanzada del mundo— establece obligaciones específicas para diferentes actores: proveedores, usuarios, importadores y distribuidores. En el caso de sistemas de alto riesgo, exige un sistema formal de gestión de riesgos, documentación técnica detallada, monitoreo post-implementación y trazabilidad.

Principios de la OCDE sobre IA

Adoptados por más de 40 países, estos principios recomiendan que los sistemas de IA sean robustos, seguros, transparentes y responsables. La rendición de cuentas es uno de los ejes centrales.

Recomendación UNESCO sobre la Ética de la IA

Un marco ético global que impulsa mecanismos de gobernanza, derechos humanos y responsabilidad organizacional para reducir impactos negativos en comunidades vulnerables.

La metáfora de la orquesta: la IA como esfuerzo colectivo

Gestionar los riesgos de IA no es como tocar un solo de piano. Es como dirigir una orquesta sinfónica. Se necesitan múltiples instrumentos, especialistas y una dirección clara.

Dentro de una organización, los siguientes equipos deben trabajar de forma coordinada:

- Equipos técnicos: científicos de datos, ingenieros de ML, MLOps

- Legal y cumplimiento: para garantizar respeto a normas y privacidad

- Ética de IA y gobernanza: guardianes de principios y evaluación de impacto

- Negocio y producto: responsables del caso de uso y experiencia de usuario

- Alta dirección: responsable final de los resultados y la rendición de cuentas

Sin una partitura común y mecanismos de coordinación (comités, políticas, gates de aprobación), el riesgo no se gestiona: se esconde.

Ejemplo aplicado: sistema de IA para contratación

Imagina que una empresa utiliza un sistema de IA para filtrar CVs. El sistema discrimina sistemáticamente a mujeres mayores de 45 años.

¿Quién es responsable?

- ¿El equipo que entrenó el modelo con datos sesgados?

- ¿El área de Recursos Humanos que lo implementó sin revisión?

- ¿El proveedor externo que diseñó el sistema?

- ¿La dirección que no asignó presupuesto para validaciones éticas?

La respuesta correcta es: todos son responsables en su nivel, pero debe haber una persona o equipo claramente accountable por cada decisión crítica. Esto solo es posible si hay una estructura de gobernanza efectiva que lo defina y lo supervise.

Más allá de la empresa: stakeholders externos

La gobernanza de IA no termina en las paredes de la organización. Una IA verdaderamente responsable también escucha e involucra a:

- Auditores externos que validen los controles implementados

- Reguladores que aseguren el cumplimiento normativo

- Grupos de sociedad civil que adviertan sobre impactos éticos y sociales

- Usuarios finales y comunidades afectadas que sufren o se benefician de la IA en la práctica

La colaboración multiactor es esencial para que el sistema sea robusto, legítimo y confiable.

Conclusión: no es opcional, es estructural

La IA no es neutral. Sus errores pueden afectar vidas reales. Por eso, las organizaciones deben avanzar de la teoría a la práctica: construir estructuras de gobernanza sólidas, definir roles con claridad y orquestar colaboraciones efectivas.

En un mundo cada vez más automatizado, la responsabilidad no puede ser un “quizás”. Debe ser parte del diseño.

¿Tu organización tiene una partitura clara para responder cuando la IA se equivoca?