“Unmasking AI”: el libro que señala los peajes ocultos de la automatización

📚 ¿Por qué leerlo?

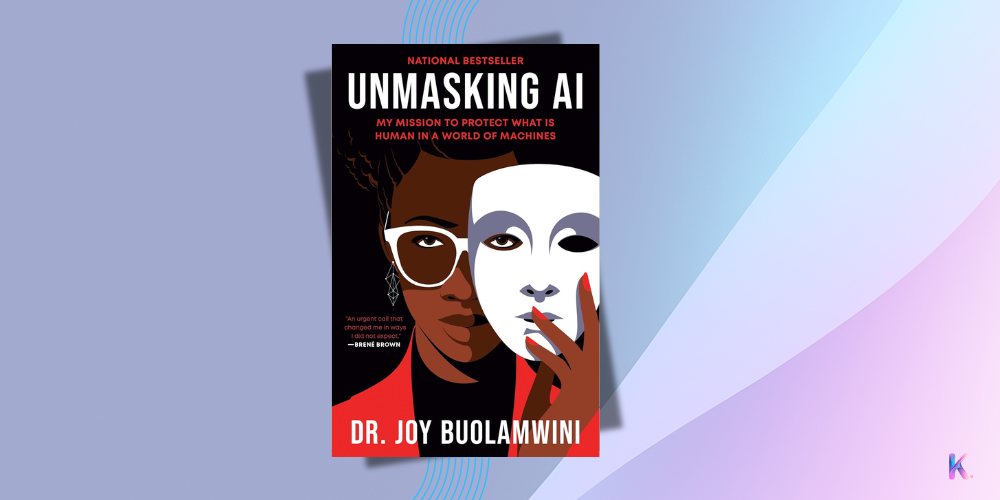

Unmasking AI: My Mission to Protect What Is Human in a World of Machines relata, en primera persona, cómo la investigadora Joy Buolamwini expuso el sesgo algorítmico racial y de género en sistemas de reconocimiento facial desarrollados por gigantes tecnológicos. A diferencia de otras obras sobre inteligencia artificial, este libro no parte de dilemas abstractos ni escenarios de ciencia ficción: su fundamento es una historia real, impulsada por la experiencia directa de una mujer negra “invisible” para un software que decide quién es visto y quién no.

Buolamwini, fundadora de la Algorithmic Justice League y autora del influyente artículo académico “Gender Shades”, lleva sus hallazgos de laboratorio al Congreso de EE.UU., foros globales y espacios activistas. El libro entrelaza análisis técnico, denuncia política y poesía. No es un manual sobre ética en IA, sino un testimonio urgente de cómo el sesgo algorítmico da forma a sistemas que ya deciden a quién se otorga crédito, vivienda o libertad.

Es lectura esencial para reguladores, profesionales de datos, activistas digitales y voces latinoamericanas comprometidas con construir soberanía tecnológica desde la justicia social. Buolamwini interpela desde un lugar que muchas veces los indicadores no computan: el cuerpo omitido.

📚 ¿Por qué importa para IA responsable / gobernanza?

- Visibiliza las fallas estructurales del entrenamiento algorítmico sobre datos no representativos, un problema común en tecnologías que se aplican en contextos desiguales sin criterios locales.

- Vincula sesgos algorítmicos con derechos civiles, mostrando cómo tecnologías “neutrales” perpetúan exclusiones históricas cuando no se diseñan con enfoque interseccional.

- Propone el concepto de “excoding”, útil para entender cómo las personas quedan fuera de los sistemas automatizados, sin derecho a réplica ni evaluación jurídica.

- Demuestra la potencia del arte, la poesía y la experiencia vivida como metodologías válidas para auditar sistemas técnicos con impacto social.

- Desarma la narrativa de inevitabilidad tecnológica, recordando que lo que entendemos por “riesgo existencial” muchas veces excluye lo que para algunos es riesgo cotidiano.

📚 5 ideas clave del libro

- Las máquinas aprenden de datos sesgados: los algoritmos de reconocimiento facial fallaban sistemáticamente en identificar rostros de mujeres negras. No por accidente, sino por entrenamiento defectuoso.

- La “mirada codificada” (coded gaze): Buolamwini usa este término para referirse al conjunto de prejuicios e intereses de quienes diseñan los sistemas. No existe algoritmo sin óptica social.

- El “excoding” como nueva forma de exclusión: no sólo se discrimina activamente, también se omite silenciosamente. Quien no aparece en los datos, sencillamente no existe para el sistema.

- Auditar con arte es auditar con poder: el poema audiovisual “AI, Ain’t I a Woman?” expone sesgos algorítmicos con imágenes y versos que desmontan la autoridad técnica con sensibilidad política.

- La regulación sin interseccionalidad es insuficiente: sin enfoques que contemplen raza, género, clase y discapacidad, las leyes de IA reproducirán injusticias en otras escalas.

📚 Citas destacadas

“The rising frontier for civil rights will require algorithmic justice. AI should be for the people and by the people, not just the privileged few.”

“You can be excoded when a tenant screening algorithm denies you access to housing. These examples are real.” (p. 165)

“Can machines see our grandmothers as we knew them?” (p. 91, del poema ‘AI, Ain’t I a Woman?’)

📚 ¿Cómo aplicarlo en la práctica?

- Haz una auditoría con usuarios reales antes de lanzar tu sistema, incluyendo poblaciones racializadas y no normativas.

- Consulta marcos de referencia como el EU AI Act o la Recomendación UNESCO sobre Ética en la IA adaptándolos a tu contexto.

- Crea procesos internos de “pre-alfabetización algorítmica” en organizaciones públicas o ONGs que usan modelos predictivos.

- No subestimes las metodologías no convencionales: usa testimonios, poesía, imágenes y demos accesibles para explicar sesgos técnicos.

- Nombra y documenta: sin evidencia comparativa no hay presión pública sobre proveedores tecnológicos.

📚 Pros y contras

Pros: Integra experiencia personal con análisis técnico, valida formas no convencionales de auditoría, aporta recursos accesibles y genera una narrativa clara contra el determinismo algorítmico.

Contras: No aborda en profundidad herramientas legales específicas fuera de EE.UU.; puede generar expectativa de cambio que las instituciones existentes aún no canalizan.

📚 Recursos relacionados

- NIST AI Risk Management Framework – para pensar auditoría algorítmica desde un enfoque de mitigación de riesgos.

- UNESCO Recomendación sobre la Ética de la IA – destaca el deber de “no discriminación y diversidad”.

- Principios de IA de la OCDE – exigencia de transparencia y supervisión humana.

- ISO/IEC 42001 – norma internacional para sistemas de gestión de IA.

- Documental Coded Bias – complementa el libro con impacto visual y entrevistas clave: en él se documenta cómo descubrió que los sistemas de reconocimiento facial no reconocían su rostro hasta que se puso una máscara blanca. La película muestra su investigación en el MIT, su testimonio en el Congreso de EE.UU., y cómo esa experiencia la llevó a crear el Algorithmic Justice League. Es una excelente introducción a los riesgos reales de la IA y al poder del activismo tecnológico con rostro humano. Me encanta este documental!

📚 Propuestas de acción concretas

- Promueve estudios de impacto algorítmico obligatorios (similar a estudios de impacto ambiental) en políticas públicas digitales en América Latina.

- Crea observatorios ciudadanos de IA donde las comunidades afectadas participen en auditorías abiertas.

- Requiere transparencia sobre el origen de los datos utilizados en sistemas de IA aplicados en decisiones públicas.

- Brinda incentivos fiscales o regulatorios a empresas que implementen pruebas de equidad algorítmica racial y de género antes de desplegar sistemas.

📚 Ficha técnica

Título: Unmasking AI: My Mission to Protect What Is Human in a World of Machines

Autora: Joy Buolamwini

Editorial: Random House Trade Paperbacks

Año: 2024

ISBN: 978-0593241844

¿Y tú?

¿Tus sistemas reconocen la dignidad de quienes históricamente fueron tratados como “ruido” en los datos?

Si diseñaras un algoritmo hoy, ¿desde dónde lo mirarías? ¿Desde el privilegio o desde la exclusión?

✅ Ve la lista completa de los libros que te recomiendo

✅ Suscríbete a mi newsletter para recibir cada semana lo más relevante de la IA Responsable

Quieres aprender más sobre la IA Responsable y Gobernanza de la IA, mira los artículos de blog que he redactado para ti.

Para cualquier duda que puedas tener, me puedes mandarme email a info@karine.ai, con mucho gusto te contestaré.