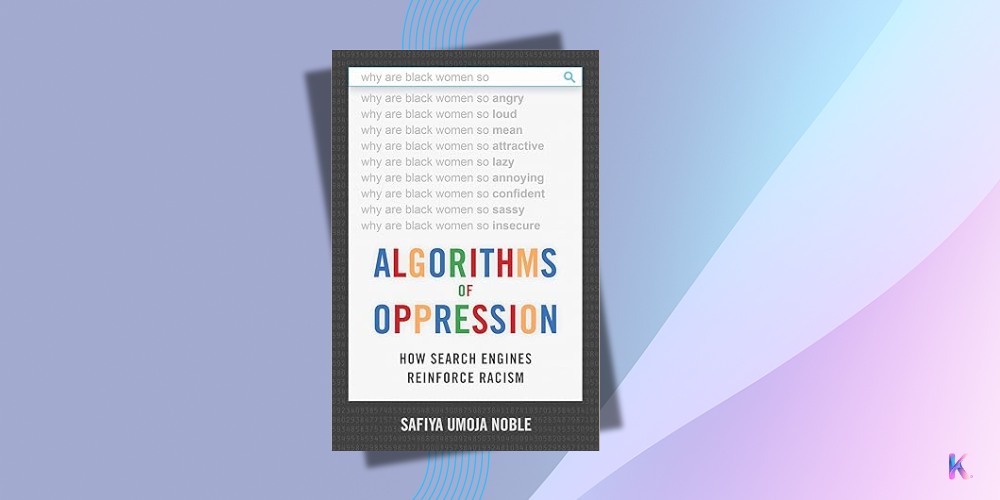

Algorithms of Oppression: How Search Engines Reinforce Racism

Cuando el buscador deja de ser un “espejo” y se convierte en un sistema que prioriza ciertos intereses: sesgos, poder y responsabilidad en la era de la información.

📖 ¿Por qué leerlo?

Algorithms of Oppression desmonta una idea muy extendida: que los resultados de los buscadores “reflejan” la realidad de forma neutral.

Safiya Noble muestra, con casos y análisis, que los motores de búsqueda están atravesados por decisiones comerciales (publicidad, SEM), reglas de ranking, selección de fuentes y datos históricos que pueden reproducir y amplificar estereotipos, especialmente contra mujeres y comunidades racializadas. El libro pone el foco en el daño representacional: cuando un sistema de información perpetúa imágenes o narrativas dañinas, no solo afecta a clics o visibilidad, afecta la dignidad, las oportunidades y la percepción pública.

Para equipos de producto, datos, comunicación y políticas públicas, es una lectura que abre los ojos: entenderás cómo decisiones “técnicas” tienen efectos sociales y políticos; por qué la proveniencia de datos, las políticas editoriales y la rendición de cuentas no son “extras”, sino controles esenciales. Noble te ofrece un marco para auditar buscadores y sistemas de recomendación con criterios éticos, de diversidad y de justicia, y te da lenguaje para dialogar (y exigir) a proveedores, plataformas y partners.

📖 ¿Por qué importa para IA responsable/gobernanza?

- Eleva el daño representacional (racial y de género) a riesgo de primer orden, no un efecto colateral.

- Conecta modelo de negocio (ads, SEO/SEM) con sesgo y visibilidad: sin alinear incentivos, las mitigaciones no escalan.

- Demanda proveniencia y trazabilidad de datos, criterios editoriales explícitos y diversidad de fuentes.

- Refuerza rendición de cuentas: divulgación de políticas de ranking, apelaciones y auditorías independientes.

- Relaciona buscadores con derechos civiles, libertades informativas y democracia.

📖 5 ideas clave del libro

Este libro te deja mucho que pensar y esencialmente estas ideas claves:

- La búsqueda online es una forma de poder informacional, no un servicio neutral.

- Los algoritmos reflejan y amplifican estructuras sociales y comerciales, además de los datos.

- La economía de la atención y la publicidad alteran qué narrativas ganan visibilidad.

- Sin proveniencia, políticas editoriales y vías de apelación, el sesgo se institucionaliza.

- Hace falta auditoría independiente, alfabetización digital y regulación basada en riesgo.

📖 Citas destacadas

Las citas del libro que más me gustaron fueron:

- “Los motores de búsqueda no son neutrales; producen efectos políticos y culturales.”

- “Lo que vemos como ‘resultado’ es el resultado de datos históricos, incentivos comerciales y decisiones de diseño.”

- “Cuando los algoritmos fallan a los márgenes, fallan a la sociedad en su conjunto.”

📖 ¿Cómo aplicarlo en la práctica?

- Publica políticas editoriales de ranking (relevancia, seguridad, diversidad de fuentes y señales negativas).

- Realiza Evaluaciones de Impacto Algorítmico con foco en representational harm y grupos afectados.

- Exige proveniencia de datos, criterios de desindexación y controles anti-pornificación/estereotipos.

- Monitorea con métricas de equidad: exposición por grupo, diversidad temática y calidad de fuentes.

- Habilita vías de apelación y correcciones rápidas cuando aparezcan resultados dañinos.

- Refuerza la alfabetización digital de equipos y audiencias (contexto, sesgo, fuentes confiables).

📖 Pros y contras

Un libro potente que combina investigación y claridad narrativa para mostrar cómo las infraestructuras de búsqueda afectan vidas reales y por qué la gobernanza no puede limitarse a “lo técnico”.

Pros: evidencia accesible y bien documentada; marco práctico para exigir transparencia y responsabilidad; útil para compras, compliance y política pública.

Contras: menos profundidad en mitigaciones algorítmicas específicas; foco principal en buscadores (requiere extrapolar aprendizajes a feeds y recomendaciones).

📖 Recursos relacionados

- OECD AI Principles — valores, transparencia y rendición de cuentas como base de gobernanza.

- UNESCO – Recomendación sobre la Ética de la IA — enfoque en diversidad, derechos y sociedad.

- NIST AI RMF 1.0 — gestión de riesgo, medición y documentación para sistemas de IA.

- EU AI Act — obligaciones de transparencia y control basadas en riesgo.

- Data Feminism (D’Ignazio & Klein) — repensar poder y datos; Ghost Work (Gray & Suri) — trabajo invisible en plataformas.

📖 Ficha técnica

Título: Algorithms of Oppression: How Search Engines Reinforce Racism ·

Autor: Safiya Umoja Noble, Ph.D. ·

Editorial: NYU Press ·

Año: 2018

✅ Ve la lista completa de los libros que te recomiendo

✅ Suscríbete a mi newsletter para recibir cada semana lo más relevante de la IA Responsable

Quieres aprender más sobre la IA Responsable y Gobernanza de la IA, mira los artículos de blog que he redactado para ti.

Para cualquier duda que puedas tener, me puedes mandarme email a info@karine.ai, con mucho gusto te contestaré.