Hoy Hablamos Sobre

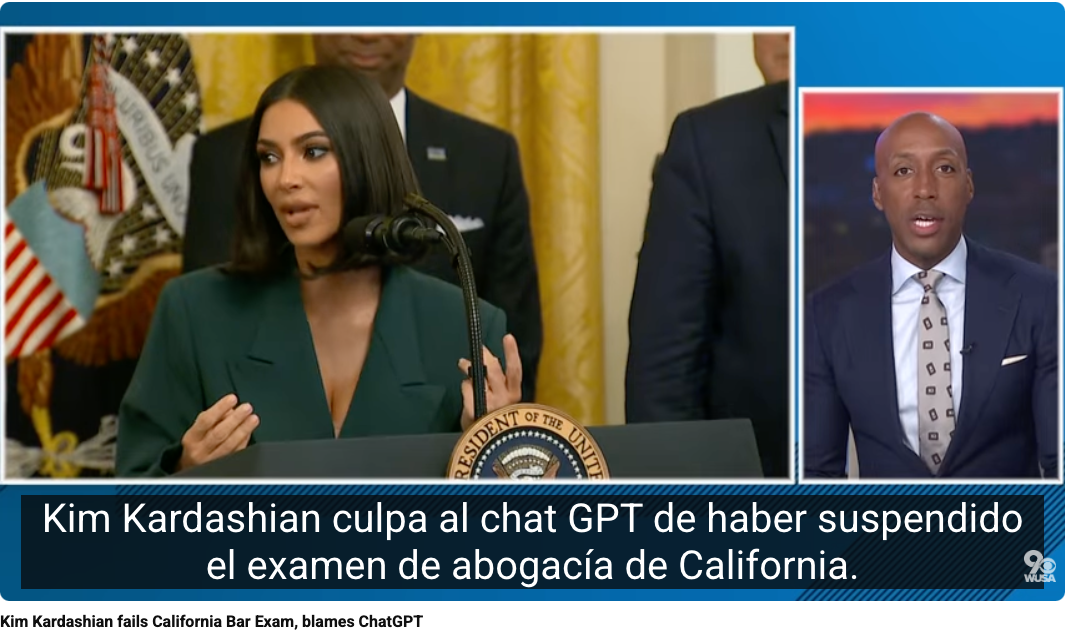

"Kim Kardashian culpa a ChatGPT por fallar el examen de abogacía!"

AI Literacy

"Kim Kardashian culpa a ChatGPT por fallar el examen de abogacía!"

Kim Kardashian confesó en una entrevista reciente que usó ChatGPT para prepararse para el examen de abogacía en California —y no lo aprobó. Dijo que usó el modelo como apoyo para sus estudios, incluso lo llamó “su amigo” y “le gritó” cuando no obtenía las respuestas que esperaba.

Más allá del titular viral, la escena abre preguntas incómodas sobre hasta dónde confiamos en herramientas como ChatGPT para tareas críticas. ¿Debería una IA reemplazar el estudio sistemático del derecho? ¿Quién es responsable cuando las recomendaciones son erróneas—el sistema, el usuario o ambos?

¿Por qué se habla de Kim Kardashian y ChatGPT en relación con su examen de abogacía?

La empresaria y figura pública Kim Kardashian mencionó en tono humorístico que el uso de ChatGPT “le jugó en contra” al preparar parte del examen de abogacía que intenta aprobar en California. Este comentario reabrió el debate sobre los límites del uso de herramientas de inteligencia artificial en contextos educativos y profesionales. Aunque la IA generativa puede ser útil para repasar conceptos o practicar preguntas, depender exclusivamente de ella puede llevar a errores, ya que sus respuestas no siempre son exactas ni actualizadas.

Ejemplo: En el ámbito académico, varias universidades han establecido guías claras para el uso de IA en exámenes y ensayos. Harvard y Stanford, por ejemplo, permiten el uso de herramientas como ChatGPT solo para apoyo conceptual, pero exigen verificación humana del contenido. El caso de Kardashian ilustra cómo la confianza ciega en la IA puede afectar la precisión y el aprendizaje real.

Lo que revela el caso: entre confianza ciega y falsas expectativas

Modelos de lenguaje como ChatGPT no están entrenados con garantías legales. Su entrenamiento es generalista, no pensado para ofrecer asesoría jurídica fiable. Aun así, en contextos cotidianos, es fácil atribuirle cualidades humanas como “inteligencia” o “responsabilidad”.

“Los LLMs no comprenden, solo predicen lo más probable que venga después. No son idóneos para tareas que requieren interpretación normativa ni razonamiento jurídico estructurado.” —Virginia Dignum

El fenómeno tiene nombre: ilusión de competencia algorítmica. Cuando interfaces conversacionales son fluidas, es fácil sobreestimar la capacidad real del sistema. Esto no solo afecta personas famosas como Kardashian. Puede influir en decisiones médicas, financieras y legales en todo el espectro social.

Oportunidades mal interpretadas

- IA generativa como apoyo para explicar conceptos complejos o resumir textos jurídicos.

- Accesibilidad para quienes no tienen formación legal, si se usa con supervisión humana.

- Herramientas como ChatGPT pueden ser útiles para entrenamiento básico, pero no sustituyen asesoramiento profesional.

Riesgos éticos y sociales

El AI Literacy es la capacitación básica a las personas para que eviten cometer este tipo de errores con los sistemas de IA:

- Confianza indebida en sistemas no validados para contextos críticos.

- Reforzamiento de la desinformación jurídica cuando no hay verificación humana.

- Responsabilidad difusa: ¿quién responde cuando una IA te “aconseja” mal?

¿Y la gobernanza?

Este tipo de episodios refuerza la necesidad de entornos regulados. El EU AI Act clasifica los sistemas por nivel de riesgo. Un chatbot jurídico requeriría, bajo ese marco, transparencia reforzada, validación ex ante y supervisión humana constante.

El estándar ISO/IEC 42001 también aboga por procesos internos que documenten límites del sistema y responsabilicen a los desarrolladores.

Lo crucial: IA ≠ fuente confiable por defecto

La anécdota de Kardashian no solo entretiene (bueno, si un poco la verdad!). Nos enfrenta con una realidad urgente: si no se educa socialmente sobre lo que una IA puede (y no puede) hacer, crecerán las decisiones delegadas erróneamente a sistemas automatizados.

¿Qué podemos hacer?

- Incluir módulos de alfabetización en IA en la formación jurídica y académica.

- Advertencias explícitas en plataformas como ChatGPT para reforzar su valor como herramienta complementaria, no sustitutiva.

- Desarrollar políticas institucionales de uso responsable de IA generativa en procesos de enseñanza, exámenes y asesoramiento profesional.

Tu turno

¿Estamos listos para convivir con herramientas que se sienten confiables pero no entienden? ¿Hasta dónde debemos responsabilizar a los usuarios por confiar en IA como ChatGPT… y hasta dónde a quienes la diseñan?

Fuente: https://www.youtube.com/watch?v=tZc_10G-jTU

¿Qué pasó con Kim Kardashian y ChatGPT en el contexto de su examen de abogacía?

Kim Kardashian, quien desde hace años estudia derecho en California, bromeó recientemente diciendo que “ChatGPT tuvo parte de la culpa” por no aprobar una parte del examen de abogacía. Aunque el comentario fue humorístico, encendió una discusión seria sobre la fiabilidad de las herramientas de inteligencia artificial generativa para fines educativos y profesionales. El incidente muestra cómo depender de modelos como ChatGPT sin verificar la información puede generar errores y confusión conceptual.

Ejemplo: Muchos estudiantes y profesionales utilizan ChatGPT para practicar exámenes o redactar ensayos. Sin embargo, si no contrastan las respuestas con fuentes académicas o bases legales actualizadas, pueden reproducir errores o interpretaciones incorrectas. En contextos regulados, como el derecho o la medicina, esto puede tener consecuencias serias.

¿Qué lecciones deja este caso sobre el uso educativo de la inteligencia artificial?

El caso de Kim Kardashian subraya la importancia de usar la inteligencia artificial como herramienta de apoyo, no como sustituto del aprendizaje humano. Los sistemas de IA pueden generar explicaciones y simulaciones útiles, pero carecen de juicio crítico, actualización normativa y comprensión contextual. Por ello, se recomienda una combinación de uso guiado por profesores o tutores humanos y revisión constante de las fuentes originales.

Ejemplo: Algunas universidades de Estados Unidos y Europa han implementado “políticas de uso responsable de IA”, donde los estudiantes pueden usar ChatGPT para resumir textos o practicar conceptos, pero deben citarlo y verificar la información con bibliografía formal antes de presentarla.

Fuente: UNESCO – Guidance for Generative AI in Education and Research (2023)

¿Por qué es un riesgo confiar ciegamente en herramientas como ChatGPT para exámenes o decisiones profesionales?

Modelos como ChatGPT generan texto a partir de patrones lingüísticos, no de comprensión jurídica o científica. Su función es probabilística, no interpretativa. Por eso, aunque las respuestas parezcan correctas, pueden contener imprecisiones, omisiones o incluso “alucinaciones” —es decir, información inventada. En contextos como el examen de abogacía, donde cada palabra tiene peso legal, este tipo de error puede marcar la diferencia entre aprobar o fallar.

Ejemplo: En 2024, un abogado en Nueva York fue sancionado por presentar un escrito judicial redactado con ChatGPT que contenía citas inventadas de casos inexistentes. Este incidente impulsó la exigencia de transparencia y supervisión humana en el uso de IA generativa en entornos legales.

¿Qué prácticas seguras recomiendan los marcos de gobernanza de IA para contextos educativos y legales?

Los marcos internacionales de gobernanza, como el NIST AI RMF y la ISO/IEC 42001, recomiendan prácticas basadas en la transparencia, la supervisión humana y la evaluación continua del riesgo. En el ámbito educativo o jurídico, esto implica declarar cuándo se utiliza IA, garantizar la revisión de un experto humano y evitar su uso en tareas donde la precisión o la ética sean determinantes.

Ejemplo: Una escuela de derecho podría implementar un protocolo donde los estudiantes usen IA solo para generar ejemplos o glosarios legales, pero no para redactar argumentos jurídicos. De igual modo, los bufetes deben establecer políticas de revisión y responsabilidad compartida cuando se emplean herramientas de IA en la preparación de casos.

Fuente: ISO/IEC 42001:2023 – Sistemas de Gestión de Inteligencia Artificial

¿Qué revela este episodio sobre la relación entre celebridades, tecnología y confianza pública en la IA?

El episodio muestra cómo las declaraciones de figuras públicas influyen en la percepción colectiva de la inteligencia artificial. Cuando una celebridad menciona fallos o éxitos con ChatGPT, millones de personas interpretan la herramienta según esa experiencia anecdótica. Esto puede distorsionar la confianza pública, ya sea generando expectativas irreales o fomentando desconfianza sin fundamento técnico. La alfabetización mediática y la educación sobre IA responsable son esenciales para equilibrar la narrativa.

Ejemplo: Tras el comentario de Kardashian, varias redes sociales se llenaron de debates sobre si “ChatGPT puede aprobar exámenes de derecho”. La situación ilustra cómo la comunicación digital moldea la opinión pública más rápido que la evidencia científica o regulatoria.

Quieres aprender más sobre la IA Responsable y Gobernanza de la IA, lee mis artículos de blog que he redactado para ti.

Si te interesa seguir explorando cómo construir IA Responsable, inscritos y te acompaño cada semana con análisis críticos, buenas prácticas y casos reales. ✅ Suscríbete a mi newsletter para recibir cada semana lo más relevante de la IA Responsable

Para cualquier duda que puedas tener, me puedes mandarme email a info@karine.ai, con mucho gusto te contestaré.

#IAResponsable #GobernanzaAlgorítmica #AlfabetizaciónDigital #RiesgoReputacional #ChatGPT